これは普通のブログ記事ではありません。今日は代わりに、簡単な動画チュートリアルをお届けします。🎥

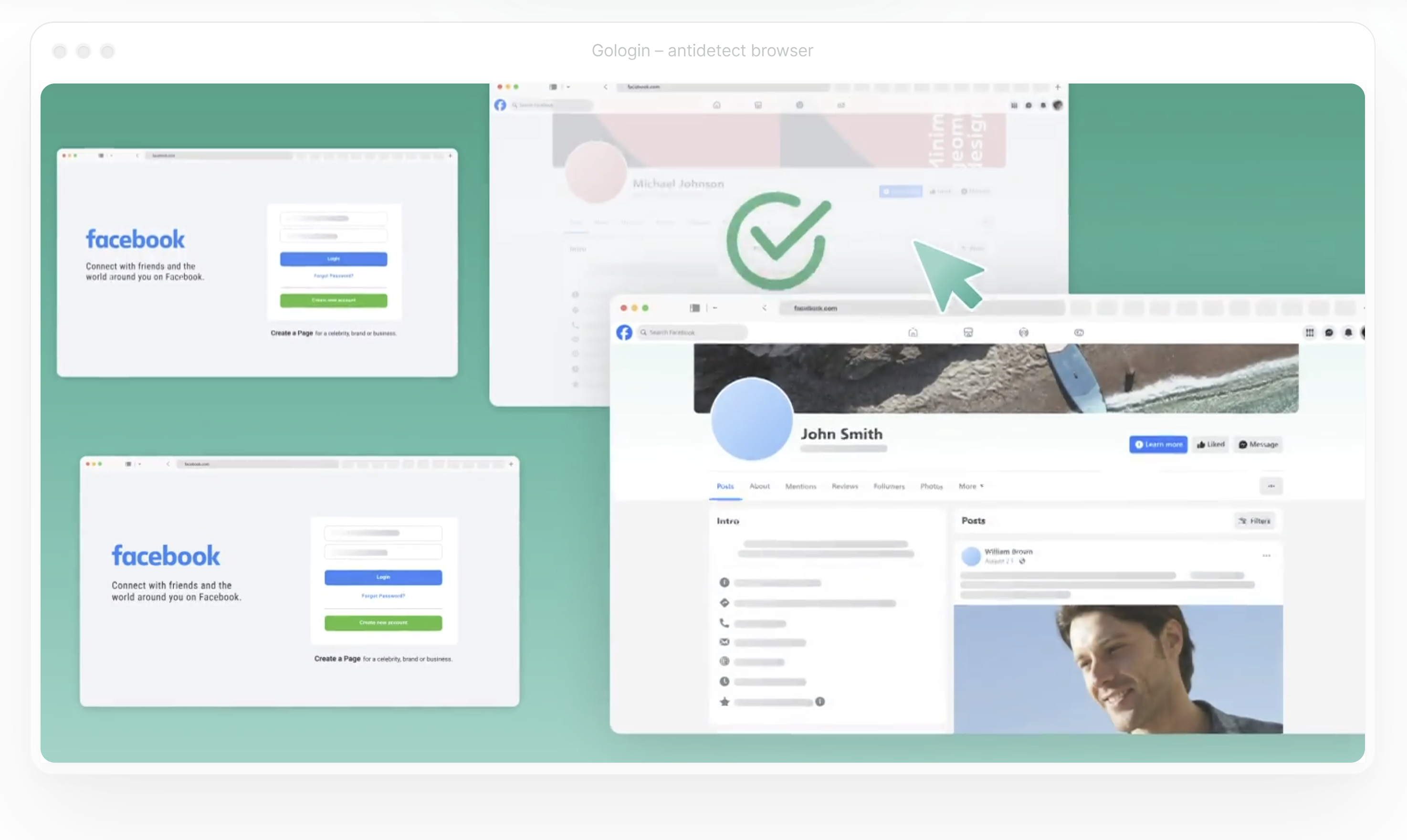

この動画では、Gologinでプロキシを設定する方法をステップバイステップでご説明します。信頼性の高いプロキシ(ProxyScrapeを使用)への接続方法を学べます。 ProxyScrape を例として使用)、設定のテスト方法、そしてブラウジングセッションを匿名化する方法を学べます。

作成者:ProxyScrape2025年10月15日

これは普通のブログ記事ではありません。今日は代わりに、簡単な動画チュートリアルをお届けします。🎥

この動画では、Gologinでプロキシを設定する方法をステップバイステップでご説明します。信頼性の高いプロキシ(ProxyScrapeを使用)への接続方法を学べます。 ProxyScrape を例として使用)、設定のテスト方法、そしてブラウジングセッションを匿名化する方法を学べます。

作成者:ProxyScrape2025年2月21日

Pythonやウェブスクレイピングが初めての方なら、「Pandas」という用語を目にしたことがあるでしょう。では、Pandasとは一体何なのか?なぜデータ分析や抽出の分野でこれほど重要なツールなのか?このガイドでは、初心者からPandasを自信を持って使えるユーザーへと、段階的に導きます。 この記事を読み終える頃には、Pandasの強力な機能の秘密と、スクレイピングしたデータを効果的に扱うための活用方法が理解できるようになります。

作成者:ProxyScrape2025年2月14日

このガイドでは、macOSでプロキシを設定する手順を段階的に説明します。特に ProxyScrape Proxiesの統合に焦点を当て、接続の安全性と信頼性を確保し、様々なユースケースに最適化します。最終的には、プロキシ設定をテストしてトラフィックが正しくルーティングされていることを確認する方法も学べます。

さあ、始めましょう!

作成者:ProxyScrape2025年2月7日

サイトマップは、検索エンジンにインデックス登録してほしいURLの構造化されたリストを提供することで、SEOとウェブクロールにおいて重要な役割を果たします。ページごとにリンクを辿ってウェブサイトをスクレイピングする代わりに、サイトマップをクロールすることは、利用可能なすべてのURLを発見するはるかに高速な方法です。

作成者:ProxyScrape2025

ウェブスクレイピングは、開発者、データアナリスト、SEO専門家にとって不可欠なツールです。競合他社の情報を収集する場合でも、データセットをまとめる場合でも、スクレイピングでは複数のデータページを移動する必要が生じることが多く、このプロセスはページネーションとして知られています。しかし、ページネーションがユーザー体験にとって有用である一方で、ウェブスクレイピングにおいては重大な課題をもたらす可能性があります。

作成者:ProxyScrape2025

ウェブスクレイピングは、インターネット全体からデータを収集するための不可欠なツールとなり、データアナリスト、技術愛好家、企業が情報に基づいた意思決定を行うことを可能にしています。しかし、データを抽出することは最初のステップに過ぎません。その真の力を解き放つには、スプレッドシート用のCSVファイル、API用のJSON、大規模な保存と分析のためのデータベースなど、適切な形式に効率的にエクスポートする必要があります。

このブログでは、ウェブスクレイピングで取得したデータをエクスポートする基本を解説します。CSVファイルやJSONファイルの扱い方、ウェブスクレイピングデータをデータベースに統合する方法、データ管理手法を最大限に活用する方法を段階的に学べます。

作成者:ProxyScrape2025

ウェブスクレイピングは、Python開発者、データサイエンティスト、そしてウェブスクレイピング愛好家にとって不可欠なスキルとなっています。分析のためのデータ抽出、価格比較ツールの構築、コンテンツ抽出の自動化など、これらのタスクの核心にはウェブ解析が位置しています。では、ウェブ解析を効率的かつ初心者にも親しみやすくする要素とは何でしょうか? ここで登場するのがParsel——HTML解析とデータ抽出を簡素化するPythonの強力なライブラリです。

作成者:ProxyScrape2024年12月25日

ウェブスクレイピングは、ウェブから情報を抽出して分析する必要がある開発者やデータアナリストにとって不可欠なツールとなっています。製品価格の追跡、研究のためのデータ収集、カスタマイズされたダッシュボードの構築など、ウェブスクレイピングは無限の可能性を提供します。